KI Open-Source-Tools: Datenschutzfreundliche Alternativen im Überblick

Fullstack und Mobile Developer

· September 2025

· aktualisiert Dezember 2025

Du interessierst dich für Datenschutz und das Thema Künstliche Intelligenz (KI)? Du willst wissen, welche KI Open-Source-Tools dir dabei helfen können, unabhängiger von externen Services zu werden und nebenbei den Schutz deiner Daten und den deiner Kund:innen auf das nächste Level zu heben?

Dein Team hat das Know-how und ist bereit, alles auf eigener Infrastruktur aufzusetzen oder nach einer kleinen Testphase mit Support eines Open-Source Dienstleisters. Es weiß aber nicht, was es auf dem Markt gibt? Dann lies gerne weiter. 🚀

In diesem Artikel

Inhaltsverzeichnis zum Thema KI Open Source

- Warum dich das Thema KI Open Source persönlich ansprechen sollte

- Was bedeutet eigentlich Open Source bei KI?

- Überblick über empfehlenswerte KI Open-Source-Tools

- Speech To Text (STT) – diktiere der KI

- Text to Speech (TTS) – lass die KI vorlesen

- Weitere Anwendungsszenarien für KI Open-Source-Tools

- 📌 Fazit: Starte jetzt mit KI Open-Source-Tools und schütze deine Daten!

Warum dich das Thema KI Open Source persönlich ansprechen sollte

Wie oft nutzt du inzwischen Chatbots? Hast du schonmal darüber nachgedacht, was die großen Anbieter:innen von Large Language Models (LLMs) wie ChatGPT, Gemini, Claude, Mistral, Grok, Deepseek, … an persönlichen Daten von dir speichern?

Was kann aus diesen Daten abgeleitet werden und welche hat man in einem unvorsichtigen Moment preisgegeben? Als Beispiel seien hier persönliche Fotos, um tolle KI-Bilder zu generieren oder Fragen nach Symptomen zu potenziellen Krankheiten, angeführt. Am Ende gelangen diese Daten womöglich als Trainingsdaten in einem Modell und sind mit dem richtigen Prompt abrufbar. Ich persönlich lege viel Wert darauf, meine Daten zu schützen, wo es möglich ist.

Einzelne ihrer Kund:innen tun das auch. Ich verweise hier nur auf die DSGVO und den AI Act, die empfindliche Strafen bei Datenschutzverletzungen vorsehen.

Zum Beispiel spricht Artikel 83 (5) der DSGVO von Strafen bis zu 20.000.000 EUR oder 4 % des gesamten weltweit erzielten Jahresumsatzes des vorangegangenen Geschäftsjahres eines Unternehmens.

Mit Junico in die neue Arbeitswelt!

Finde die richtigen Freelancer:innen für dein nächstes Projekt oder suche nach spannenden Aufträgen, die zu deinen Skills passen.

Was bedeutet eigentlich Open Source bei KI?

Du fragst dich sicher, wie Open Source helfen kann, mehr Datenschutz zu gewährleisten. Wir haben kaum Einfluss darauf, was die großen Anbieter an Daten sammeln und was sie damit anfangen, wenn wir ihre Angebote nutzen. Wäre es nicht super, wenn wir selbst die Kontrolle hätten und diese Dienstleister nicht benötigen würden? Dann hätten nur wir die Daten.

Das ist möglich mit freier, quelloffener Software (Free and open-source software / FOSS), die bei Bedarf mit eigener Infrastruktur betrieben werden kann. Open Source wird häufig als Synonym verwendet, jedoch umfasst FOSS mehr. Deswegen sollten wir definieren, was das genau bedeutet.

Freie Software als Grundlage von KI Open Source

Ich nutze die Definition der FSFE für freie Software. Stark zusammengefasst heißt das: frei nutzbar, untersuchbar, veränderbar und verbreitbar. Frei heißt hier im Sinne von Freiheit, nicht im Sinne von Preis. Bekannte Lizenzen sind zum Beispiel: MIT, GPL-3.0-only und Apache 2.0.

Per Definition müssen alle folgenden vier grundlegenden Freiheiten gegeben sein, sonst ist die Software als unfrei anzusehen:

Verwenden

Freie Software darf für jeden Zweck genutzt werden und ist frei von Einschränkungen wie dem Ablauf einer Lizenz oder willkürlichen geografischen Beschränkungen.

Verstehen

Freie-Software-Code darf ohne Vertraulichkeitsvereinbarungen oder ähnliche Einschränkungen von allen untersucht werden.

Verbreiten

Freie Software darf praktisch kostenfrei kopiert und weitergegeben werden.

Verbessern

Freie Software darf beliebig modifiziert und angepasst werden. Verbesserungen dürfen weitergegeben werden.

Vorteile von Open Source

✅ Autonomie – kann an eigene Bedürfnisse angepasst werden

✅ Zusammenarbeit und Communitys – dient dem Gemeinwohl

✅ Weitergeben & Kopieren – keine Lizenzkosten

✅ Kein Lock-in-Effect – stärkere Unabhängigkeit von einzelnen Anbietern

✅ Einfachere Wiederverwendung von Code

✅ Innovationsfördernd und Lerngelegenheit – Ideen sind einfach nachzuvollziehen

✅ Stärkt Wettbewerb – Monopolisierung ist schwerer

✅ Bessere Sicherheit – unabhängige Sicherheitsprüfungen möglich

✅ Oftmals kostenlos angeboten

Nachteile von Open Source

❌ Vielen Open-Source-Projekten fehlen die finanziellen Mittel, daraus ergeben sich viele der nachfolgenden Punkte (unterstützt diese Projekte!)

❌ Oft fehlender oder unzureichender kommerzieller oder technischer Support

❌ Manchmal unzureichende, unvollständige, nicht aktualisierte Dokumentation

❌ Fehlende Garantie auf Qualität und Sicherheit

❌ Keine Garantie auf langfristige Unterstützung, manchmal nur ein einzelner Maintainer

❌ Lizenzdschungel, je nach Anwendungsfall mit entsprechenden Rechten und Pflichten

❌ Höherer Eigenaufwand

Was sind KI Open-Source-Tools?

In diesem Text bezeichnen Open Source KI-Tools Werkzeuge bzw. Programme oder Bibliotheken, die es ermöglichen, KI-Modelle zu nutzen. Diese stehen unter einer Open-Source-Lizenz für freie Software.

Manchmal ist der Übergang zu den KI-Modellen, häufig LLMs, fließend. Jedoch bezieht sich diese Definition nicht auf die KI-Modelle. In den meisten Fällen bezeichnen Unternehmen ihre Modelle als Open Source, obwohl nur die Gewichte verfügbar sind. Damit wird es schwierig zu verstehen, wie das Modell funktioniert und es zu einem bestimmten Zweck zu verändern.

Es fehlen die Trainingsdaten und wie man das Modell reproduzieren kann. Damit sind nicht alle vier Freiheiten gewährleistet.

Leider sind nur sehr wenige Modelle verfügbar, die der obigen Definition von vollständig offen entsprechen. (z. B. OLMo 2) Deshalb werden hier zumindest auf eigener Hardware nutzbare, im weitestgehenden Sinne offene, KI-Modelle aufgelistet.

Genau die Jobs, die du jetzt brauchst

Finde spannende Projekte von mehr als 3.000 Unternehmen.

Überblick über empfehlenswerte KI Open-Source-Tools

Ich habe mich hier auf eine kleine Auswahl beschränkt und die Werkzeuge nach folgenden weiteren Kriterien ausgewählt:

✅ möglichst geringer Aufwand beim Aufsetzen auf eigener Hardware

✅ breite oder eine Vielzahl an Einsatzmöglichkeiten

✅ eigene Erfahrung und Verwendungszweck in der Zukunft

|

Tool |

Wofür? |

Lizenz |

|

KI-LLM Modelle selber hosten |

||

|

Benutzer:innenfreundliche KI-Schnittstelle als Weboberfläche |

||

|

leistungsfähige und modulare GUI, API und Backend mit Graphen/Knoten Oberfläche basierend auf Diffusions-Modellen |

||

|

Low-code Programmierung für Event-basierende Anwendungen |

||

|

KI-Paar-Programmierungswerkzeug im Terminal |

||

|

Transkribieren, STT |

||

|

Transkribieren, STT |

||

|

TTS |

||

|

TTS, Training für TTS |

Du willst deine Tätigkeit als Freelancer:in aufs nächste Level heben?

Dann komm in die Junico Community und starte direkt!

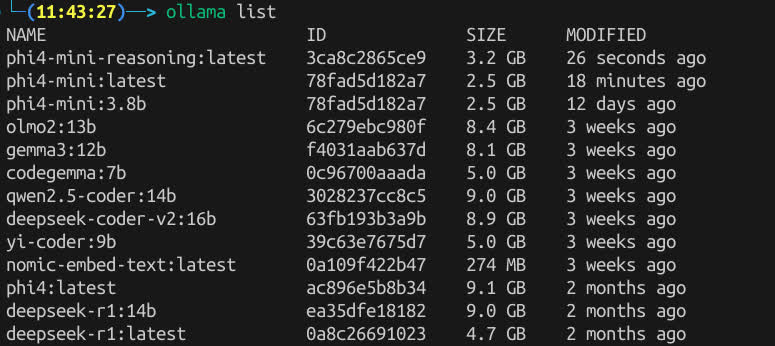

Jetzt registrieren!Ollama – ein Backend für KI Open Source Anwendungen

Ollama stellt die eigentliche KI zur Verfügung, hier die Large Language Models. Das sind spezielle KI-Modelle, hier neuronale Netze, trainiert auf einem Großteil der verfügbaren Texte der Menschheit.

Im Grunde genommen gibt man diesen Modellen Text und sie geben wahrscheinlichkeitsbasiert passenden Text zurück. Das kann sich anfühlen, als würde eine echte Person mit dir sprechen / texten. Ollama übernimmt dabei die Kommunikation zwischen dir und den Modellen.

Um bei dem Vergleich Mensch zu bleiben – bei einem Treffen zum Thema KI wurde das jeweilige LLM als künstliches Gehirn bezeichnet. Ollama betreibt die künstlichen Gehirne und beeinflusst damit die Antworten und deren Stile, so wie auch wir Menschen verschieden sind.

Nun etwas technischer:

Ollama ist ein Backend Service, mit dem man LLMs hosten kann. Man kann ihn lokal auf dem eigenen PC installieren oder auf einem eigenen Server.

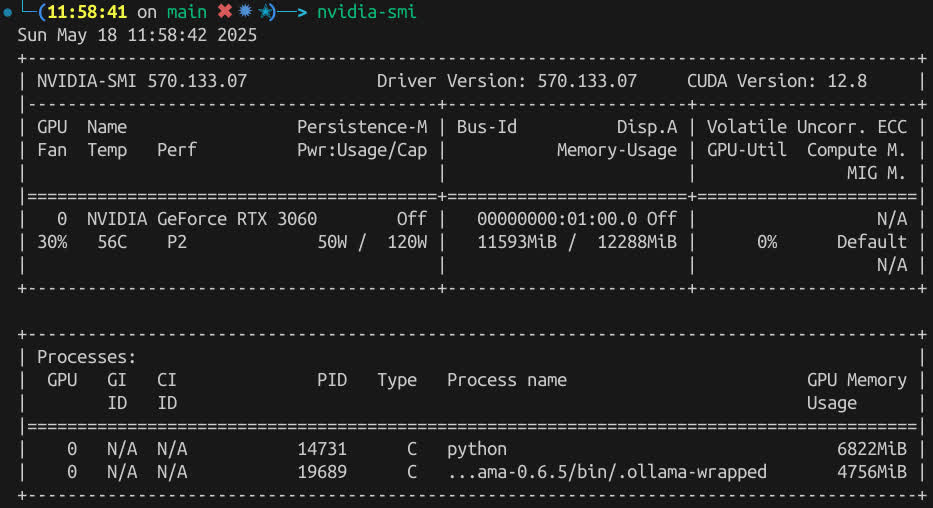

Die Installation ist für die drei größten Betriebssysteme Linux, MacOS und Windows verfügbar. Man kann sich auch isolierte Umgebungen durch Virtualisierung mit gängigen Programmen wie Docker oder Podman erstellen lassen. Ollama unterstützt Berechnungen auf einer Grafikkarte und beschleunigt damit die Rückgabe der Antworten des LLMs.

Es bildet damit die Grundlage für viele weitere Services, die ein solches LLM nutzen.

Es unterstützt eine Vielzahl an verfügbaren KI-Modellen und deren Parametrisierungen. Jeder Anbieter hat sich dafür besondere komisch klingende Namen ausgedacht, wie Gemma 3, QwQ, Deepseek, Llama, Phi, Mistral und viele weitere. Es lassen sich auch KI-Modelle anpassen und im Safetensor oder GGUF Format importieren. Diese Formate sind speziell für die neuronalen Netze der LLMs strukturierte und optimierte Dateien. Damit stehen auch weitere Modelle von anderen Quellen wie Hugging Face zur Verfügung.

Mit dem Service lässt sich über eine Kommandozeile (CLI) kommunizieren oder eine REST API (spezielle Anwendungsschnittstelle) ansprechen.

💡 Ich möchte nicht unerwähnt lassen, dass zum Zeitpunkt der Erstellung des Artikels v0.6.18 die aktuellste Version ist und die API nach Semantic Versioning somit jederzeit geändert werden kann.

Als Alternative sei hier noch llama.cpp angeführt. Damit kann man

sich die Ausgaben bzw. Folgerungen (Inferenz) der LLMs in den Programmsprachen C/C++ generieren lassen. Allerdings ist dies nicht so nutzer:innen-freundlich wie Ollama und man muss sich mehr mit dem Setup beschäftigen. Dafür hat man noch mehr Möglichkeiten, das Setup zu optimieren.

Des Weiteren gibt es eine Vielzahl an Community-Integrationen zu entdecken, erwähnt sei hier Open WebUI, welches wir uns als Nächstes anschauen.

Vorteile von Ollama

✅ Lokal und offline nutzbar

✅ Datenschutz und Sicherheit

✅ Einfache Installation und Nutzung

✅ Leichtgewichtig und effizient

✅ Kostenfrei und Open Source

✅ Integration mit anderen Tools

✅ einfaches Laden, Löschen und Wechseln von Modellen

Nachteile von Ollama

❌ nicht alle Modelle vorhanden, aber trotzdem viele Gute

❌ Keine Weboberfläche, dafür gibt es andere Tools

❌ kein Training, nur Inferenz

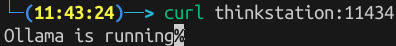

Open WebUI – dein persönlicher KI-Assistent

Open WebUI ist eine nutzer:innen-freundliche KI-Benutzer:innen-Oberfläche.

Es lassen sich unzählige APIs verknüpfen. Speziell für uns relevant ist die Kommunikation mit der Ollama REST API. Es gibt aber auch die Möglichkeit, andere OpenAI-kompatible APIs anzuschließen. Als Beispiele seien hier LMStudio, GroqCloud, Mistral oder OpenRouter genannt.

Vom Umfang her ist Open WebUI die KI-Open-Source-Software mit den meisten und wichtigsten Funktionen. Ich zähle hier nur ein paar im KI-Kontext auf:

✅ mit einem LLM chatten

✅ Sprach- und Videoanruf

✅ Native Python Funktionsaufrufe

✅ lokales Retrieval Augmented Generation (RAG)

✅ Websuche für RAG

✅ Webbrowsing Integration in den Chat

✅ Bildererstellung mit AUTOMATIC1111 API, ComfyUI oder OpenAI's DALL-E

✅ feingliedriges Nutzer:innen- und Gruppenrechtemanagement

✅ Role-Based Access Control (RBAC)

✅ Pipelines und Plugin Support

Die Installation erfolgt mit Python oder Docker und ist somit auch für alle Betriebssysteme möglich. Man kann direkt auch Ollama mit integriert installieren.

💡 Auch hier noch der Hinweis, zum Zeitpunkt der Erstellung des Artikels ist v0.6.18 die aktuellste Version und die API kann sich jederzeit ändern.

Ich nutze Open WebUI momentan mit Phi4:latest 14.7B, wenn ich schützenswerte Daten eingebe. Ich würde auch größere Modelle nutzen, aber mein lokaler "KI-Server" ist durch meine Grafikkarte eingeschränkt, eine NVIDIA GeForce RTX 3060 mit 12 GB Speicher.

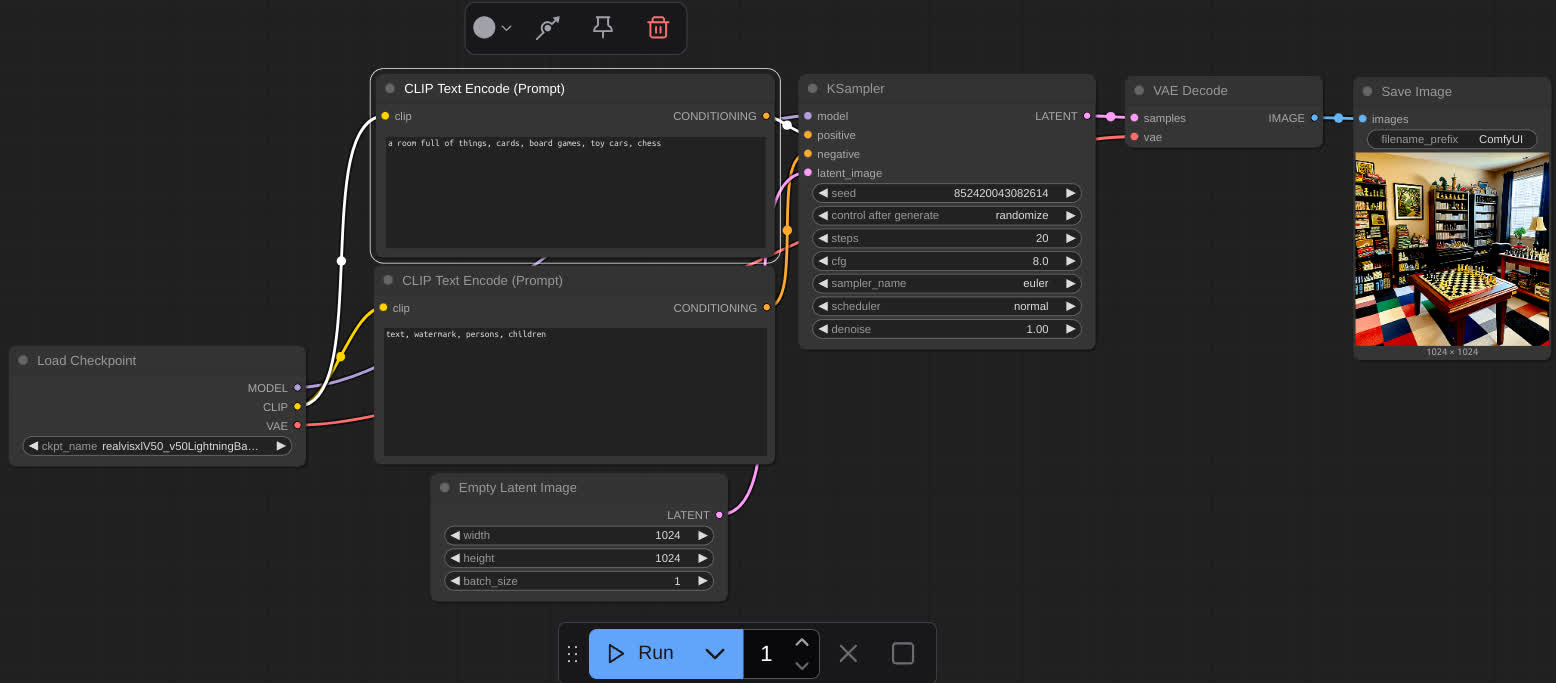

Ausprobiert habe ich auch die Websuche mit meiner eigenen Homepage und das Hinzufügen von Dateien zum Kontext. Mit der ComfyUI-Anbindung wurden direkt ein paar Bilder erstellt.

Alternativen sind zum Beispiel AnythingLLM und LibreChat.

Vorteile von Open WebUI

✅ Benutzer:innenfreundliche Oberfläche, ähnlich zu den bekannten Chatbots in der Cloud

✅ Nahtlose Integration mit Ollama

✅ Kostenfrei und Open Source

✅ Erweiterbar mit Plugins

✅ Schnelle Installation via Docker oder Node.js

✅ Viele Features

✅ Starke Entwickler:innen-Community

Nachteile von Open WebUI

❌ Weboberfläche verbraucht zusätzliche Systemressourcen

❌ Nicht für mobile Geräte optimiert

❌ Weniger polished als kommerzielle Lösungen

❌ Manuelle Updates nötig

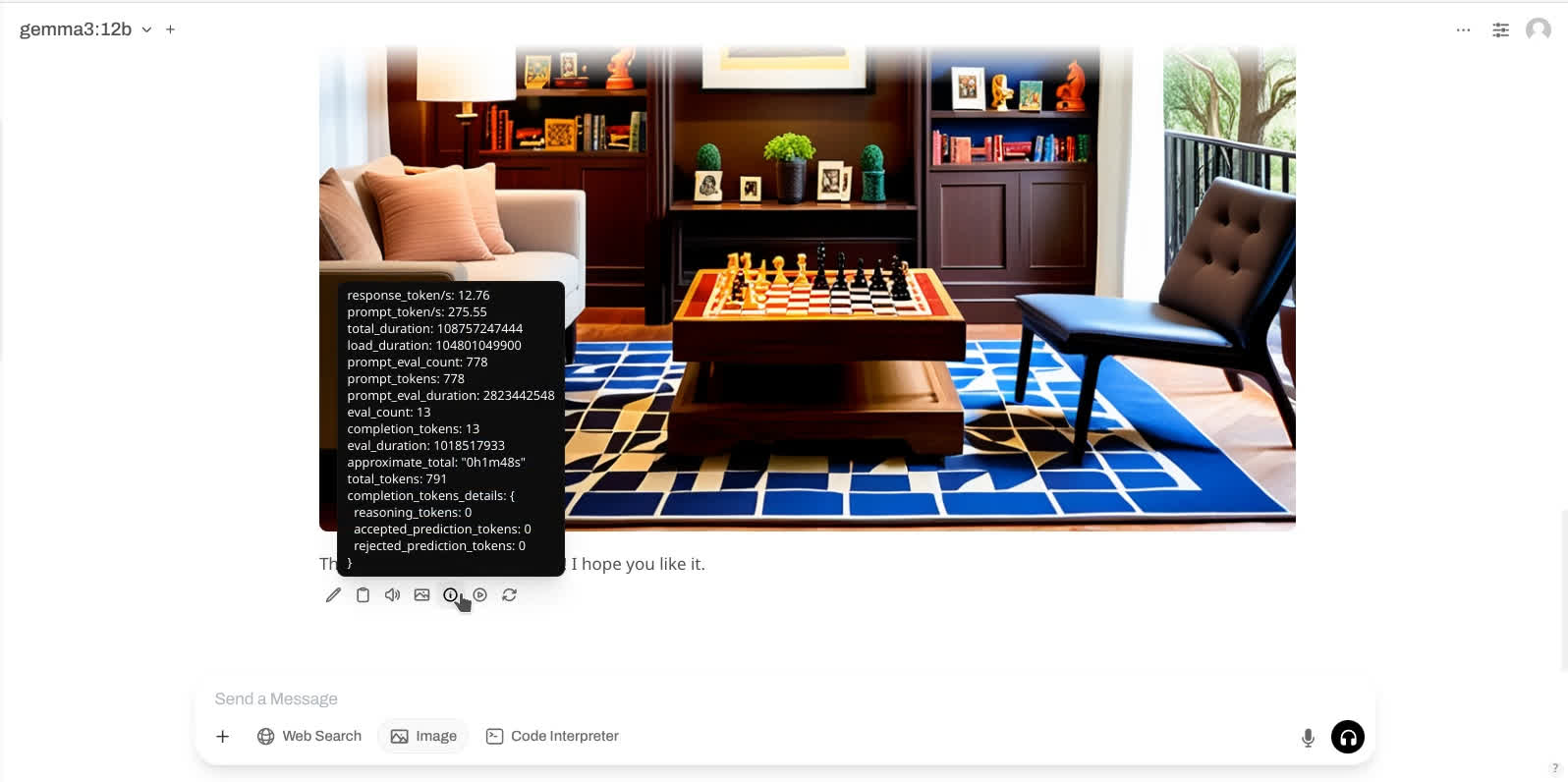

ComfyUI – dein Bild- und Videogenerator

Mit diesem Tool kann man hauptsächlich Bilder und Videos erzeugen oder bearbeiten. Dabei wird generative KI genutzt.

Hier die grobe Übersetzung der Selbstbeschreibung auf Github:

Die leistungsfähigste und modulare Diffusions-Modell GUI, API und Backend mit Graphen/Knoten Oberfläche.

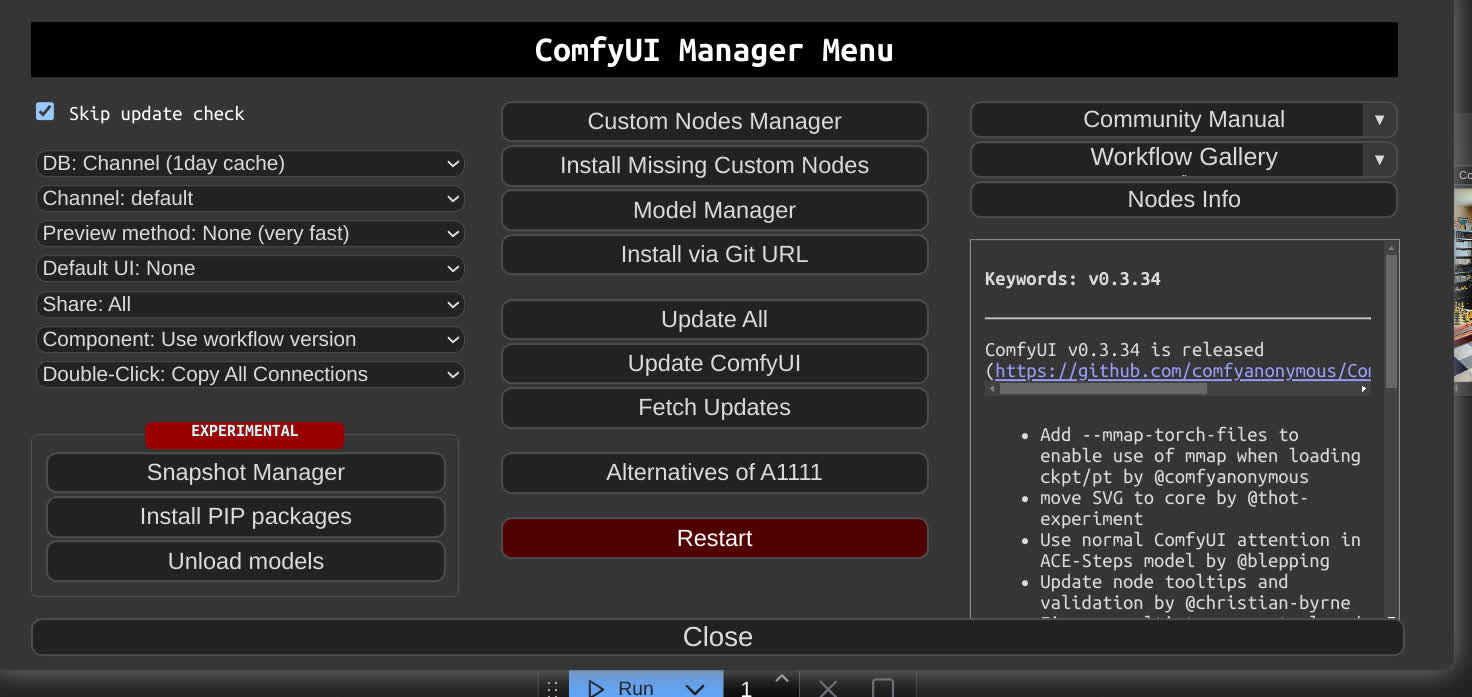

Ob es die leistungsfähigste GUI ist, kann ich nicht einschätzen, aber das modulare Design mit den Knoten und daraus resultierenden Graphen bzw. Flowcharts spricht mich definitiv an. Es fördert das Verständnis, was vor sich geht und was beim Teilen der Graphen extrem wichtig ist. Es gibt viele vorinstallierte Knoten. Jedoch müssen weitere Knoten, Modelle und Checkpunkte installiert werden, wenn man komplizierte Workflows nachbilden will. Dabei kann ComfyUI-Manager helfen, welches als Extension hinzugefügt wird. Ansonsten ist Pythonerfahrung von Vorteil, um die Fehler beim Installieren zusätzlicher Knoten zu beheben.

Die Community hat eine Menge beeindruckender und reproduzierbarer Beispiele auf openart.ai oder civitai.com erstellt.

Die Software ist auch Crossplattform, also für Linux, MacOS und Windows erhältlich. Auch hier ist noch keine stabile API erschienen, da der Versionsstand aktuell v0.3.46 ist. ComfyUI funktioniert sowohl mit CPU als auch mit GPU, wobei letzteres schneller Bilder generiert.

Vorteile von ComfyUI

✅ Visuelle, modulare Arbeitsweise (Node-Editor)

✅ Maximale Kontrolle über den Workflow mit Feineinstellungen

✅ Extrem erweiterbar durch Custom Nodes

✅ Große Community

✅ Kostenfrei und Open Source

✅ Automatisierung und Scripting

Nachteile von ComfyUI

❌ Hohe Einstiegshürde für Anfänger, da schon einfache Workflows kompliziert sein können

❌ Benötigt manuelle Einrichtung

❌ Kein klassisches UI wie bei anderen generativen Bild KI Cloud-Tools

❌ Dokumentation teils unübersichtlich, viele verteilte Community Posts

Node-RED – Workflow Verknüpfung

Node-RED ist Low-code Programmierung für Event-basierende Anwendungen. Analog zu ComfyUI klickt ihr euch euren Workflow als Graphen mit Knoten zusammen. Ihr fragt euch, was das mit KI zu tun hat?

Auf den ersten Blick nichts. Allerdings sind das Senden und Empfangen von Daten an unsere KI-Modelle nichts anderes als Events. Also lassen sich hiermit auch super KI-Anwendungen erstellen.

N8n ist eine sehr bekannte Alternative, hat jedoch keine komplett offene Lizenz. Rivet wollte ich euch ursprünglich vorstellen, ist allerdings nur als Desktopanwendung vorhanden und nicht so stabil wie Node-RED, welches es schon in Version 4.0.9 gibt.

Kestra.io sieht auch vielversprechend aus.

Vorteile von Node-RED

✅ Intuitive, visuelle Programmierung

✅ Modularität und Erweiterbarkeit

✅ Kostenfrei und Open Source

✅ Aktive Community und umfangreiche Dokumentation

✅ Vielseitige Einsatzmöglichkeiten, auch abseits von KI

Nachteile von Node-RED

❌ Kein KI-First Tool

❌ Leistungsgrenzen bei hoher Last, da Node.js basiert

❌ Begrenzte Debugging- und Fehlerbehandlung

❌ Sicherheit hängt stark von der Konfiguration und den eingesetzten Knoten ab

Aider – dein Pair Programming Assistent

Es ist ein KI-Paar-Programmierungswerkzeug im Terminal. Die Idee ist, dass sich die KI mittels Chat steuern lässt und programmiert. Dabei hat sie Zugriff auf das Dateisystem, erstellt Dateien und Ordner, committed mit git, übernimmt Linting und Testing. Außerdem kann man Bilder und Webseiten hinzufügen und damit interagieren. Die Chateingabe ist auch mittels Sprache möglich und eröffnet damit eine ganz neue Dimension in der Programmiererfahrung.

Aider ist für alle Betriebssysteme mit Python installierbar. Man kann Modelle über die Ollama API oder OpenAI-kompatible APIs nutzen. Tendenziell funktionieren die Modelle mit mehr Parametern besser und die, die speziell auf Coding trainiert wurden. Im Idealfall probiert man mehrere Modelle aus oder wechselt das Modell, wenn man an einer Stelle nicht weiterkommt bzw. ein Fehler sich nicht beheben lässt. An jeder Stelle lässt sich der Assistent nutzen und dann ohne oder nur noch mit geringer Nutzung weiter programmieren. Für Prototypen lässt sich mit Aider viel Zeit einsparen.

Es gibt eine große Anzahl an Einstellungsoptionen zum Anpassen und verschiedene Modi, um direkt den KI-Assistenten programmieren zu lassen oder vorher die Anweisungen zu diskutieren. Auch hier kann sich die API noch verändern, da wir bei Version v0.85.0 sind.

Vorteile von Aider

✅ Nahtlose Git-Integration

✅ unterstützt Programmiersprachen, welche das zugrunde liegende LLM unterstützt

✅ Kostenfrei und Open Source

✅ Interaktive Terminal-Oberfläche

✅ auch Cloud Modelle von bekannten Anbietern nutzbar

✅ Kostenkontrolle durch nutzungsbasierte Abrechnung bei Nutzung der Cloud

✅ IDE-Integration durch Dateiüberwachung möglich

Nachteile von Aider

❌ Steile Lernkurve, da CLI Tool

❌ Qualität ist Abhängigkeit von der Qualität der KI-Modelle

❌ Kosten durch externe API-Nutzung können erheblich sein

❌ Potenzielle Sicherheitsbedenken bei externer API teils erheblich

Speech To Text (STT) – diktiere der KI

Was versteht man unter Speech-To-Text? Es ist die Umwandlung von Sprache zu Text und wird auch transkribieren genannt. In diesem Text werden keine kompletten Anwendungen vorgestellt, sondern nur Python Pakete bzw. Bibliotheken.

Bekannt ist Faster Whisper eine Reimplementierung von OpenAI's Whisper Modell mithilfe von CTranslate2. Sie ist bis zu 4x schneller als openai/whisper. Von Primeline gibt es auch mehrere Whisper Modelle, zum Beispiel primeline/whisper-tiny-german-1224, welches bei mir mit einem kleinen Experiment gut funktioniert hat. Anwendungsbeispiele sind, aus Videos Subtitel zu erstellen oder Podcasts transkribieren.

Vorteile von STT

✅ Zeitersparnis bei der Texteingabe

✅ Automatisiertes Transkribieren

✅ Barrierefreiheit

✅ Alternative zum Tippen

✅ Multitasking-fähig (nebenbei Laufen, Kochen, …)

✅ Integration mit KI- und Assistenzsystemen

✅ Direkt mit Übersetzung möglich

✅ Kostenfreie und Open Source Modelle wie Faster Whisper

Nachteile von TTS

❌ fehleranfällig

❌ nicht für jede Umgebung geeignet (z. B. Großraumbüro)

❌ Datenschutzproblem, wenn andere mithören

❌ Korrekturaufwand nötig

❌ Qualität variiert mit verwendetem Modell

❌ für optimale Ergebnisse ist Training oder Anpassung notwendig

Text to Speech (TTS) – lass die KI vorlesen

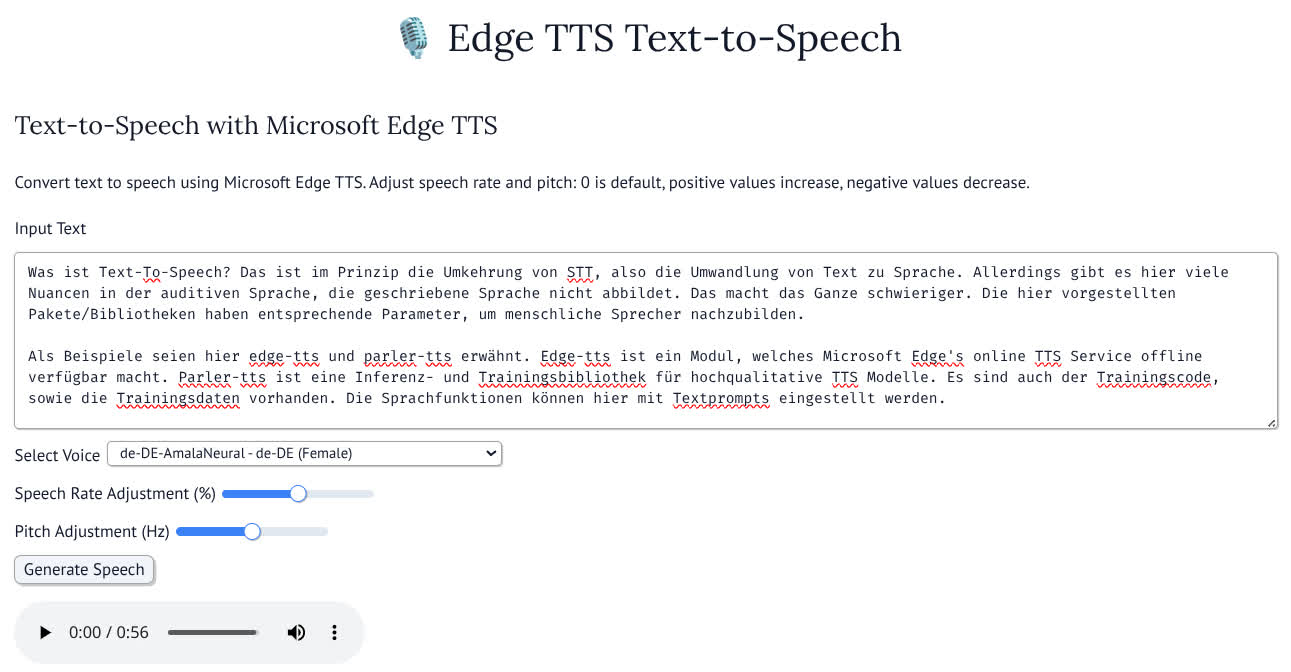

Was ist Text-To-Speech? Das ist im Prinzip die Umkehrung von STT, also die Umwandlung von Text zu Sprache. Allerdings gibt es hier viele Nuancen in der auditiven Sprache, die die geschriebene Sprache nicht abbildet. Das macht das Ganze schwieriger. Die hier vorgestellten Pakete / Bibliotheken haben entsprechende Parameter, um menschliche Sprecher:innen nachzubilden.

Als Beispiele seien hier edge-tts und parler-tts erwähnt. Edge-tts ist ein Modul, welches Microsoft Edge's online TTS Service offline verfügbar macht. Parler-tts ist eine Inferenz- und Trainingsbibliothek für hochqualitative TTS Modelle. Es sind auch der Trainingscode, sowie die Trainingsdaten vorhanden. Die Sprachfunktionen können hier mit Textprompts eingestellt werden.

Vorteile von TTS

✅ Barrierefreiheit

✅ Multitasking-fähig (nebenbei Sport, Auto fahren, …)

✅ Einfache Integration in Systeme

✅ Sprachvielfalt & Personalisierung

✅ Automatisierung

✅ Einfache Lern- und Hörzugänge für Sprachen und Inhalte

Nachteile von TTS

❌ Künstlicher Klang, wird aber immer besser

❌ Begrenztes Sprachverständnis, damit wird Ironie, Betonung oder Kontext nicht hörbar

❌ Fehler bei Aussprache (z. B. Eigennamen, Abkürzungen, …)

❌ Datenschutz und Ethik ist zu beachten bei Personalisierung mit Nutzer:innendaten

Weitere Anwendungsszenarien für KI Open-Source-Tools

Die verschiedene LLMs (geladen mit Ollama) können über Open WebUI für Folgendes genutzt werden:

✅ Übersetzungen

✅ Zusammenfassungen, Nachforschungen, Wiederauffinden von Informationen

✅ Entwürfe, Ideengenerierung

✅ Inhaltserstellung von zum Beispiel: E-Mails, Blogposts, Artikel in bestimmten Stilen

✅ Geschichten erzählen

✅ Schreibassistent für Bewerbungen, Lebensläufe, …

✅ Grammatik und Schreibverbesserungen

✅ Einfache Sprache für Barrierefreiheit

✅ Chatbots

✅ Bild- und Objekterkennung

✅ Schrift- und Zeichenerkennung

Node-RED kann in Kombination mit Ollama, TTS oder STT für Folgendes genutzt werden:

✅ Agentensysteme

✅ E-Mail-Sortierung: Kategorisierung und Organisieren

✅ Podcastgenerierung, Audiobooks

✅ Transkriptionen von Audiobooks oder Podcasts

✅ Erinnerungen erstellen

✅ Automatische Kalenderevents

✅ Empfehlungen generieren

✅ Sprachassistent

ComfyUI:

✅ Bilder- und Videoerstellung

✅ Bearbeitung

✅ Erweiterungen

✅ Gesichtsaustausch

✅ Hintergrundentfernung

✅ Umwandlung von Raster- in Vektorgrafik

✅ Kleidung virtuell anprobieren

💡 Hinweis: Es sollte immer beachtet werden, dass hier von den LLMs keine 100 % korrekte Antworten erwartet werden können und man immer noch einmal gegenlesen und überprüfen sollte.

Freelancer:innen, die du sonst nicht findest

Ausgewählte Freelancer:innen direkt kontaktieren.

📌 Fazit: Starte jetzt mit KI Open-Source-Tools und schütze deine Daten!

KI Open-Source-Tools geben dir die Kontrolle über deine Daten zurück – ohne auf moderne KI-Funktionalitäten zu verzichten. Du kannst leistungsfähige Anwendungen lokal nutzen, erweitern und individuell anpassen. Wage den Schritt und teste die besten Open-Source-Tools selbst: sicher, flexibel und voll im Trend. Deine KI – deine Regeln.

- Mit Ollama hast du das Gehirn für die Textgenerierung deines Chatbots.

- Open WebUI ist eine bequeme Weboberfläche, um deinen Chatbot mit weiteren Funktionen auszustatten und zum Beispiel Wissensdatenbanken zu nutzen.

- ComfyUI ist deine lokale Bildgenerierung oder sonstiger generativer KI mit knotenbasierendem Workflow.

- Node-RED bietet dir eine ebenfalls knotenbasierende Umgebung zum Automatisieren von Workflows. KI Workflows lassen sich leicht erstellen und einbinden.

- Aider ist dein Pair-Programming Assistent in der Kommandozeile.

- Speech To Text mit Faster Whisper ermöglicht dir Audio zu transkribieren und somit als Text zu lesen.

- Text To Speech mit EdgeTTS vertont deinen Text und wandelt ihn in gesprochene Sprache um.

Der Fortschritt in der KI ist rasant und nimmt weiter Fahrt auf. Es entwickeln sich ständig neue Ideen. Viele werden als Open-Source-Projekte umgesetzt. Nutze die Vorteile von Open Source und KI, unterstütze die zugehörige Community und verringere deine Abhängigkeit von einzelnen großen Playern. Nebenbei kannst du noch Wissen aufbauen, deine Daten schützen und etwas fürs Gemeinwohl tun.

Häufig gestellte Fragen

Was versteht man unter „KI Open Source“?

„KI Open Source“ bezeichnet frei verfügbare Software und Tools, mit denen du KI lokal nutzen, verändern und weiterverbreiten kannst – meist mit vollem Zugriff auf Quellcode und ohne Daten an Drittanbieter zu senden. Es lassen sich bei Bedarf auch Drittanbieter APIs nutzen.

Warum sollte ich Open-Source-KI statt kommerzieller Dienste nutzen?

Open-Source-KI ermöglicht dir Datenschutz, Kontrolle über deine Daten und individuelle Anpassung – ideal für sensible Anwendungen oder eigene Hardwarelösungen.

Welche KI Open-Source-Tools eignen sich besonders für den Einstieg?

Einsteiger:innenfreundliche Tools wie Ollama, Open WebUI oder Node-RED lassen sich leicht installieren, bieten vielseitige Funktionen und benötigen keine tiefgehenden Programmierkenntnisse.

Dir hat dieser Artikel gefallen? Sag es weiter…

Fullstack und Mobile Developer

Alexander ist ein technikbegeisterter Computernerd mit einer Leidenschaft für Linux, Open-Source, sowie KI-Tools. Als Fullstack- und Mobile-Entwickler integriert er gerne Künstliche Intelligenz in seine innovativen Lösungen, um die digitale Zukunft zu gestalten.

Tide – Banking, das mit deinem Unternehmen mitwächst

Eröffne dein Geschäftskonto, erhalte 50 € Startguthaben von Junico und sichere dir 200 € Prämie bei 1.000 € Kreditkartenumsatz. Steuere deine Finanzen zentral in der Tide App, erstelle Rechnungen mit Logo und profitiere von kostenloser Mastercard, Echtzeit-Überweisungen und deutschem Support.

Keine Kommentare

Melde dich an, um mitzureden!

Wie denkst du über den Artikel? Melde dich an und teile deine Meinung zum Thema!

KI im Design: Was Unternehmen beim Einsatz von KI-generiertem Design bedenken sollten

KI im Design verändert kreative Prozesse: Unternehmen nutzen künstliche Intelligenz, um Designs schneller, effizienter und vielseitiger zu gestalten. Doch rechtliche Fragen, Qualitätskontrolle und Markenkonsistenz bleiben entscheidend. Wie du konkret von KI im Design profitierst, erklärt dir Jakob.

Bild-KI im zukunftsorientierten Brand-Design: Praktische Tipps zur Entwicklung kohärenter Bildwelten

Bild-KI verändert das Brand-Design grundlegend: Entdecke im Artikel von Sandra, wie du konsistente Bildwelten entwickelst, Workflows optimierst und kreative Kontrolle behältst. Mit praxisnahen Tipps, Tools und Checklisten wird deine visuelle Kommunikation effizienter – ohne deine Expertise zu ersetzen.

Virtuelle Assistenz als Zukunftsmodell der Arbeit – digital, dezentral, dynamisch

Virtuelle Assistenz ist mehr als remote Zuarbeit: Sie steht für ein flexibles, digitales Arbeitsmodell der Zukunft. Von E-Mail-Management bis Social Media, von Projektorganisation bis Automatisierung – VAs bringen Expertise und Freiheit zugleich. Erfahre von Elke, warum immer mehr Unternehmen auf virtuelle Assistent:innen setzen und welche Chancen das Modell bietet.

So funktioniert Junico

Self-Service

Handpicked

Ihr behaltet alles selbst in der Hand.

Auftrag erstellen

Auftrag erstellen

Erstellt kostenfrei einen Auftrag und beschreibt, welche Skills, welchen Umfang und welche Erfahrung ihr sucht.

In Prüfung

Inserat optimieren lassen

Wir prüfen euer Gesuch und optimieren es bei Bedarf – damit es die richtigen Freelancer:innen erreicht.

Bewerbungsphase

Bewerbungen erhalten

Passende Freelancer:innen bewerben sich direkt mit Profilen, Anschreiben und Honorarvorstellungen.

Auswahlphase

Freelancer:innen auswählen

Ihr entscheidet, mit wem ihr sprechen möchtet, führt Interviews und klärt alle Details direkt.

Projektstart

Zusammenarbeit starten

Wählt eure Favorit:innen aus, organisiert sie in eurem Pool und startet die Zusammenarbeit.

Abwicklung

Sicher abrechnen

Behaltet alle Aufwände im Blick, erhaltet Rechnungen und bezahlt einfach und sicher über Junico.

Wir sind Junico

Wir gestalten die neue Arbeitswelt, indem wir Freelancer:innen befähigen, mit ihren Skills die Welt zu verändern.

Expert:innen für dein Projekt

Wir verbinden euch mit Freelancer:innen, die ihr sonst nicht findet. Ob Startup oder Corporate — kleines oder großes Projekt: Passende Freelancer:innen für euch.

/5

Durchschnittliche Bewertung von über 4.000 Auftraggeber:innen

Finde passende Freelancer:innen

Beauftrage schnell und flexibel Freelancer:innen mit passenden Skills. Alle Freelancer:innen sind über Junico automatisch versichert.

/5

Durchschnittliche Bewertung von über 4.000 Auftraggeber:innen

KI Open-Source-Tools: Datenschutzfreundliche Alternativen im Überblick